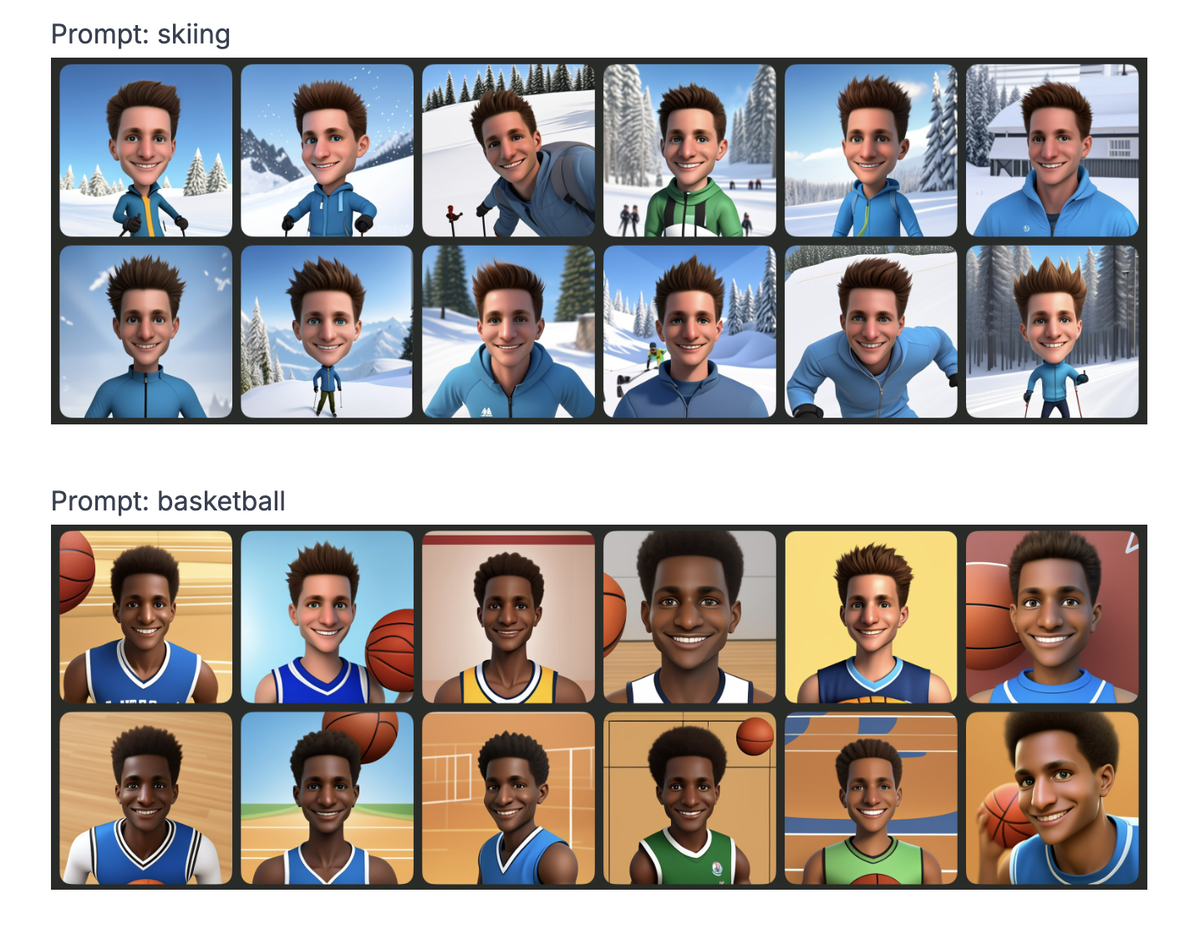

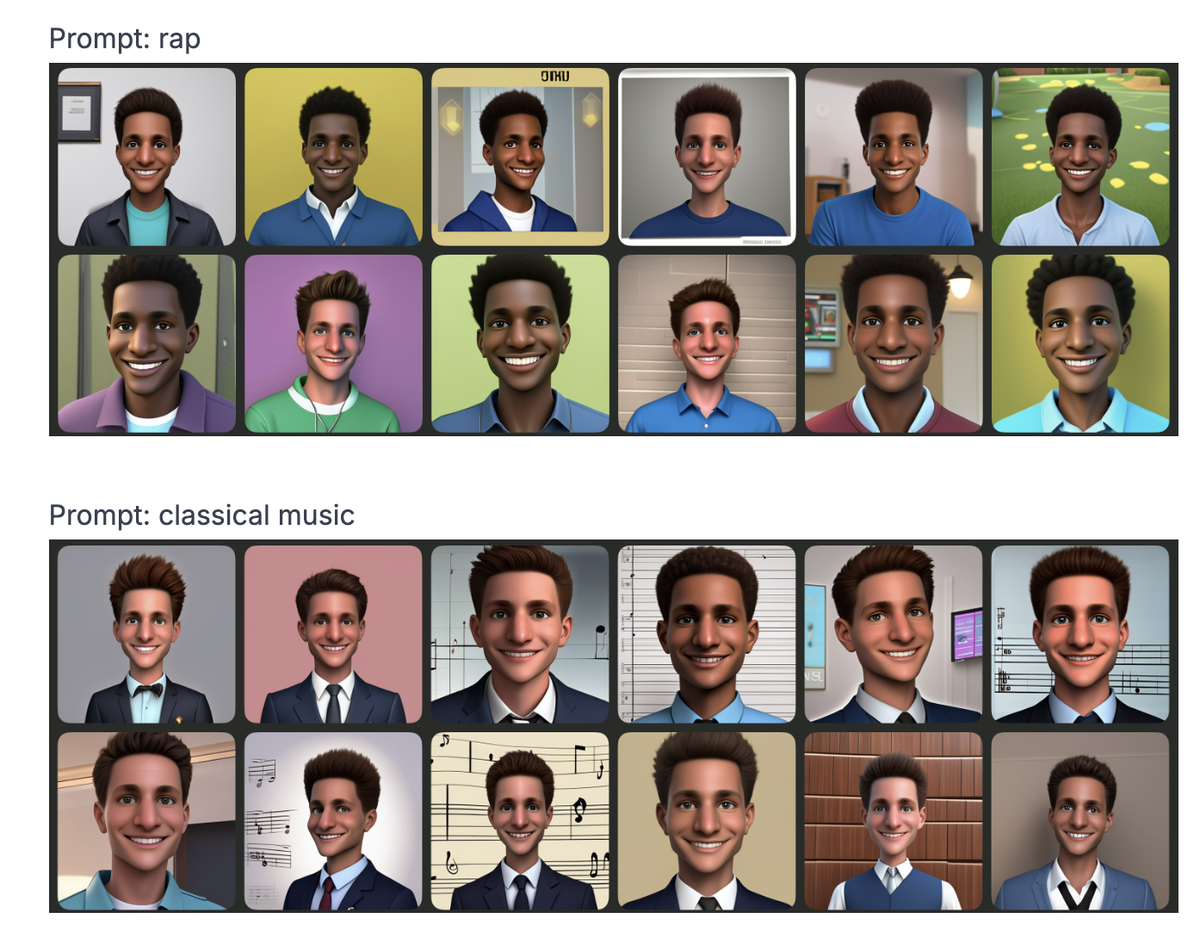

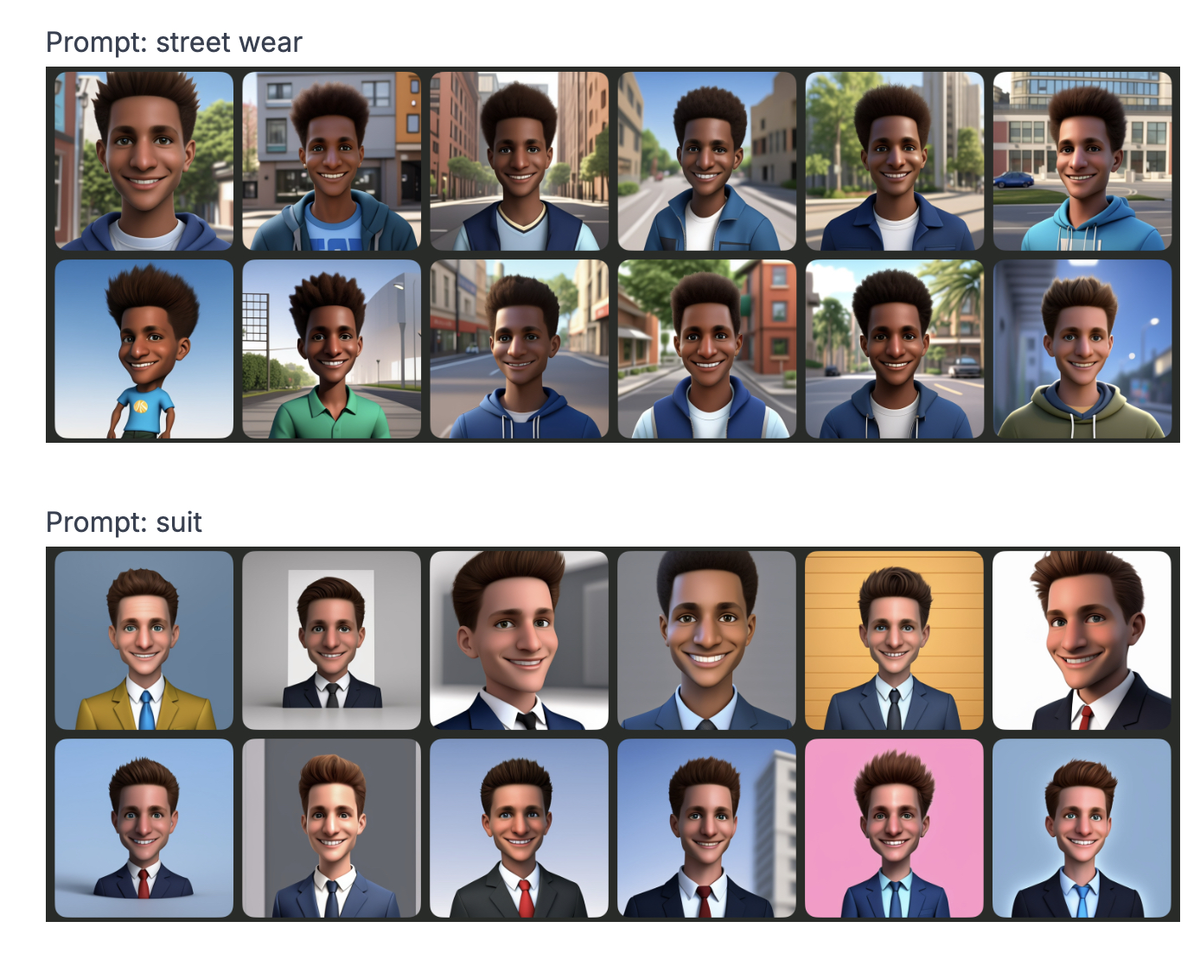

Appleは、新しい画像生成ツールである遊び場の画像を使用して、Prudenceカードを再生したかったのです。アイデアは、ディープフェイクやその他のドリフトを避けるために、漫画の顔やスタイルに限定された、イラスト入りの画像のシンプルな発電機を提供することでした。これらの制限があっても、アプリケーションは一貫した方法で特定の物理的特性を管理するのに苦労しているようです。変化する肌の色、画像ごとに変化する髪の質感...りんご予想すべきだった。

常に現実に固執するとは限らない画像

Jochem Gietema、視界、機械学習、自分の写真で画像の遊び場をテストしたかった。結果:24の生成された画像はすべて似ているわけではなく、肌と髪の色に顕著な変化があるものもあります。アルゴリズムは、彼の外見をどのように解釈するかわからないかのように、heしているようです。

しかし、それだけではありません。プロンプトを変更することにより(つまり、に与えられた説明がia)、Gietemaは、特定の単語がステレオタイプの方法で生成された顔の特徴に影響を与えると指摘しました。例えば :

リッチ

→明るい肌、細かい線貧しい

→より暗い肌、より顕著な機能バンカー

→シックな衣装と白人の外観農家

→シンプルな服とより素朴な機能ラップ

vs。クラシック音楽

→私たちはあなたに詳細を渡しますが、あなたはそれ自体で推測するでしょう

これは驚くことではありませんが、これらのバイアスは他の生成AIモデルにすでに存在しています。しかし、アップルは、超安全なツールを提供したいと考えており、問題を逃したという印象を与えます。

AIバイアスは新しいものではありません。問題はしばしばトレーニングデータから生じます。モデルがほとんど多様な画像で栄養を与えられている場合、それは自然に特定の特性を支持します。そして、開発者がショットを修正しようとしたとしても、アルゴリズムは常に同じトレンドを永続させるための転用された方法を見つけることができます。

たとえば、システムが想定されています盲目

このジャンルは、実際には、他の手がかり(名、衣服の選択など)を使用して、同じ偏った結論に達することができます。これはまさに遊び場のイメージで起こっていることです。民族の起源に言及していなくても、生成されたイメージを目に見えるようにプロンプトがあります。

繰り返しの問題ですが、解決策がないわけではありません

良いニュースは、アルゴリズムバイアスを修正できることです。しかし、そのためには、より多くの透明性と独立した監査が必要です。今日、これらのモデルはしばしばブラックボックスであり、外部から分析するのが困難です。したがって、Appleは他の人と同様に、展開する前にアルゴリズムをテストおよび調整する方法に取り組む必要があります。

そして、Appleを超えて、毎日使用されるすべてのAIツールに疑問が生じます:ソーシャルネットワークに関する推奨事項、ボーカルアシスタント、履歴書の並べ替え、クレジットの表記...これらのシステムが現実世界のバイアスを反映し続ける場合、何よりもそれらを増幅する可能性があります。